Uno dei meriti del ministro Gelmini è stato certamente quello di potenziare l'INVALSI. La raccolta di dati, effettuata in modo sistematico e continuativo, non può che essere utile, anzi, è una delle poche strade che possono consentire ai genitori e ai dirigenti scolastici di valutare l'operato di scuole ed insegnanti. Come questi dati debbano essere usati è un altro paio di maniche. È giusto che questi dati siano diffusi, ma occorre aiutare genitori e contribuenti a valutarli.

Il dirigente scolastico, nel commentare nella circolare i dati che riprenderò in seguito, avverte che:

molte sono le variabili che concorrono a definire i risultati illustrati dalle tabelle, i cosiddetti dati di contesto che l’INVALSI cerca di raccogliere e controllare, ma che ancora non ha restituito ai singoli Istituti per un’analisi scientificamente rigorosa delle prestazioni. Possiamo quindi dire con certezza che il contesto familiare ed ambientale in cui la scuola opera sostiene e favorisce il lavoro di istruzione ed apprendimento organizzato a scuola.

Il contesto socio-economico della scuola (un quartiere periferico ma mediamente agiato di una media città veneta) è favorevole, ma nonostante l'avvertenza di cui sopra il dirigente si lascia scappare la seguente conclusione:

I nostri risultati di eccellenza ci permettono di dire con sicurezza che il lavoro nella nostra scuola persegue gli obiettivi istituzionali che la Repubblica affida ai propri insegnanti, mentre alcuni risultati al di sotto della media nazionale ci portano a riflettere sulle aree in cui bisogna maggiormente lavorare

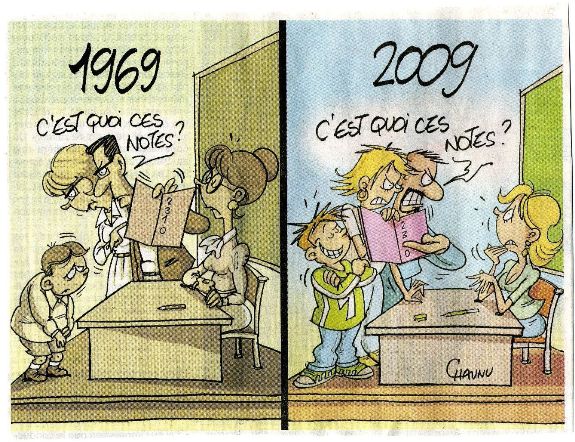

Direi che le cautele espresse nel precedente paragrafo erano più che opportune e che sarebbe stato meglio astenersi da qualsiasi valutazione. Certe tabelle in mano alle persone sbagliate (a naso, il 99% dei genitori) si prestano ad interpretazioni sbagliate.

|  |

| Risultati elementari (cliccare per ingrandire) | Risultati medie (cliccare per ingrandire) |

Le tabelle (vedi figura) contengono risultati ottenuti dagli alunni di seconda e quinta elementare, e prima e terza media. Vengono riportati i punteggi medi ottenuti nelle principali materie di studio. Ho segnato con in rosso i numeri sui quali mi soffermerò nei miei commenti. Per ciascuna prova, veniamo informati della media ottenuta dagli studenti della scuola in questione, e delle medie ottenute da tutti gli studenti del Veneto, del Nord-Est, e della media italiana. Oltre alla media, vengono riportati il "limite inferiore"e il "limite superiore", che immagino corrispondano in termini statistici ad un intervallo di confidenza.

1. Un confronto difficile

La prima cosa che fa un ricercatore di fronte a dati di questo tipo è depurarli delle condizioni socio-economiche dell'area in cui si trova la scuola, che è il PRIMO fattore determinante per il successo scolastico.Questo è un fatto abbastanza assodato in letteratura. Un 20% di genitori laureati in più fa aumentare la media molto più che la presenza di un bravo insegnante, o altre risorse di varia natura. Bastano 5 bambini stranieri in più per fare abbassare la media in modo significativo. Per esempio: 5 stranieri su 25 fanno il 20%. Se questi 5 prendono 20 punti in meno degli altri, la media si abbassa di 4 punti. Questo ovviamente non significa che i bravi insegnanti non servano (per usare una famosa metafora, il fatto che le cause della miopia sono genetiche non significa che gli occhiali non servano ai miopi). Però come commenta il dirigente, il "contesto familiare ed ambientale" è importante, e, aggiungo io, senza un'adeguata considerazione di tale contesto è piuttosto difficile poter capire quanto bene la scuola stia facendo. La tabella invita per sua natura a confrontare i risultati degli alunni di questa scuola con le medie regionali e nazionali, ma questo confronto si presta ad interpretazioni azzardate.

2. Il significato dei numeri

La circolare non fornisce una comprensione adeguata di come state poste e valutate le domande. Quanto significativa è la differenza fra un risultato di 65 ed uno di 61 (i numeri evidenziati nella tabella dei risultati della III media)? Non sto parlando di significatività statistica, ma di significatività "economica" (ossia che porta a conseguenze rilevanti sul futuro economico-sociale dell'alunno): quali conoscenze sono necessarie per ricevere 65 piuttosto che 61? Magari la differenza è minima, o magari per ricevere 65 occorre saper risolvere equazioni differenziali. Andrebbero perlomeno informati i genitori di quale sia il risultato ritenuto soddisfacente per ciascuna classe di alunni considerata. Sarebbe anche interessante sapere, piuttosto che la media ottenuta, quale percentuale di alunni ottiene questo risultato minimo.

3. Il valore aggiunto

Immaginiamo che la differenza fra 65 e 61 dell'ultima tabella (III media) sia "economicamente significativa", e che quella fra 46 e 51 (I media) lo sia pure, in segno contrario. Questo ci permette (in teoria) di calcolare il cosiddetto "valore aggiunto" della scuola (in realtà occorrerebbe prima depurare i dati dalle condizioni socio-economiche, ma assumiamo che questo sia stato fatto). Oramai questo è il criterio "standard" di valutazione - mi riprometto di parlarne in dettaglio maggiore in un prossimo post. Il confronto rivela che alla prima media sono arrivati alunni scarsi e sono usciti bravi nel giro di due anni. Per essere certi di questa valutazione sarebbe meglio avere i dati rilevati *sugli stessi alunni*, e cioé avere i dati della I media di 2 anni fa per confrontarli con la III di quest'anno. Magari la terza contiene 3 stranieri, e la prima di quest'anno ne contiene 8 perché gli stranieri stanno aumentando. Magari gli stranieri erano 8 sia in prima che in terza, ma in prima non sanno l'italiano, in terza si e tutto ad un tratto sanno fare i conti (e li sapevano fare anche prima solo che non capivano il problema loro assegnatogli).

4. La volatilità dei dati

Ignorando queste critiche, e assumendo invece una certa " stabilità " demo-economico-sociale delle famiglie nel tempo, come si spiega che gli alunni sono sulla media in V elementare e scarsini in prima media? Succede qualcosa durante le vacanze dopo la V? Il confronto fra i dati di matematica della V elementare e quelli della III media fa sospettare che alla fine questi dati siano abbastanza volatili.

5. Alcuni consigli per l'INVALSI

Dati comunicati in questo modo possono essere utili ma rischiano anche di creare confusione e fraintendimento. Confesso di non averci pensato molto, ma io spingerei per definire chiaramente quali sono i livelli minimi di apprendimento ritenuti accettabili, e riportare la percentuale di alunni che hanno superato questi livelli, piuttosto che il risultato medio. Sarebbe inoltre utile riportare altre informazioni sulla distribuzione dei risultati: qual è per esempio il valore minimo ottenuto dal 20% di studenti più bravi nell'intera nazione? Quanti studenti di questa scuola ottengono quel risultato? Servirebbe a capire se la scuola consente agli studenti bravi di ottenere un apprendimento eccellente.

Andrebbero anche aiutati i genitori a capire quali sono i livelli di apprendimento ritenuti "buono" e "ottimo" dagli esperti pedagogisti (e perché). Nelle rilevazioni dell'OCSE (TIMMS e PIRLS per le elementari e medie, PISA per le superiori) le linee guida indicano un certo numero di livelli, descrivendo quale tipo di abilità cognitiva ed intellettuale sono necessarie ad ottenerli, e a quale punteggio corrispondono nei test (si veda per esempio la descrizione di due diversi livelli di lettura che ho riportato in questo post sui PISA). L'INVALSI cura le indagini OCSE per l'Italia, e usa simili criteri. Ho scorso brevemente il rapporto completo del 2010 (nel sito dell'invalsi sono disponibili anche le appendici tecniche con informazioni sulle domande fatte agli studenti - ringrazio il lettore Carriero per avere segnalato il rapporto in un commento). Esiste un notevole sforzo effettuato perché le rilevazioni siano informative. Occorre uno sforzo ulteriore per divulgare le informazioni in maniera utile e comprensibile. Il confronto fra media della scuole e medie regionali e nazionali è informativo, ma si può fare meglio.

Consiglio agli interessati la lettura del rapporto linkato. Credo basti chiunque a fugare eventuali dubbi sul rischio che gli inseganti smettano di insegnare le cose che contano per passare il tempo ad insegnare a "fare i test". Se i test sono congegnati bene, non c'è questo rischio. Non sono un esperto di questo, ma a giudicare dalle domande che ho letto, non riesco a capire come si possa insegnare a passare il test se non si insegnano le conoscenze fondamentali della lettura, della comprensione del testo, dell'uso degli strumenti della matematica.

6. Appendice tecnica: il significato degli intervalli di confidenza

Questo è un punto importante ma un po' tecnico, che anche molti esperti fanno fatica a capire. Cito dalla circolare il seguente passaggio:

[i dati della scuola] vanno confrontati con i relativi risultati delle diverse aree facendo attenzione se rientrano o meno nell’intervallo di confidenza indicato dai limiti inferiore e superiore di ogni dato di confronto (i limiti inferiore e superiore stanno a dimostrare come differenze di mezzo punto non siano statisticamente significative, e a volte non sono significative nemmeno differenze di 2 punti).

[testo corretto il 25/1] I dati contengono l'intervallo di confidenza perché anziché riportare le medie non sono calcolate sull'intera popolazione, ma su un campione rappresentativo (per poterle riportare più velocemente, presumo). Rimane il fatto che sarebbe più opportuno focalizzare l'attenzione di genitori e dirigenti scolastici su un concetto di significatività diverso da quella statistica, come ribadito sopra. Sapere che un +2 punti pone la scuola su una posizione statisticamente migliore che rispetto alla media italiana può non significare, concretamente, granché.

Concludo osservando che i dati vanno certamente diffusi per dare modo ai genitori di operare la scelta scolastica in modo informato. Occorre però adoperarsi perché il significato di questi dati sia compreso nel modo meno distorto possibile.

Da fonte di prima mano (moglie docente in ITA) posso chiarire che si tratta di un campione, nel senso che non tutte le scuole fanno la prova INVALSI ma che nelle scuole in cui vengono fatte, tutti gli studenti vengono testati.

con anche solo 100 scuole (5 per regione, meno di 1 per provincia) e 50 studenti ciascuna fanno 5mila studenti. Per avere un intervallo di confidenza di +/0 2 la varianza campionaria deve essere 5000, il che corrisponde ad uno scarto quadratico di 70, poco credibile. E sono stato molto parco con le assunzioni sul campionamento. 50 studenti per scuola sono pochi, e 1 sola scuola campionata per provincia mi sembra poco pure.