Breve cronistoria degli eventi.

Ricerca 1 (anno 2010):

Il nostro risultato principale è che [...] i tassi mediani di crescita per Paesi con debito pubblico superiore all’incirca al 90% del PIL sono inferiori di circa l’1% [Più precisamente, la Figura 2 mostra come storicamente la crescita mediana del PIL sia di poco superiore al 3% se il rapporto deficit/PIL è al di sotto del 90%, mentre sia di poco superiore al 2% se il rapporto è al di sopra del 90%, ndr]

Ricerca 2 (anno 2012):

La crescita media annua del PIL è del 3,5 per cento per l’intero periodo in cui il debito/PIL è meno del 90%. Il rispettivo valore medio per periodi di debito eccessivo (sopra al 90% del PIL, ndr) è 2,3 per cento (cioè 1,2 per cento più basso che in periodi con debito inferiore) [...]

Ricerca 3 (anno 2013):

Il gap effettivo (in termini di crescita del PIL, ndr) tra la categoria più alta (quella sopra il 90%, ndr), e la seconda categoria più alta del rapporto debito/PIL è dell’1 per cento (cioè 3,2% meno 2,2%).

Tre distinti lavori di ricerca, tre metodologie diverse, pubblicati in tre anni diversi. I riferimenti citati indicano tutti la medesima conclusione sostanziale, e cioè che la correlazione fra crescita e indebitamento pubblico è negativa per soglie di indebitamente debito sufficientemente alte. In particolare, ad un indebitamento superiore al 90% del PIL è statisticamente associata una riduzione nel tasso di crescita dell’economia di circa l’1%. Val la pena qui di notare che una correlazione negativa fra elevati indebitamenti pubblici da un lato, e crescita del PIL dall’altro, non è ottenuta solo dai tre studi sopra riportati. Piuttosto, si tratta di un generale risultato nella letteratura empirica.

Abbiamo dunque il seguente Risultato empirico, cui più volte, in questo post farò riferimento,

Risultato: molti studi concordano sul fatto che per diversi Paesi, con diverse caratteristiche economiche, e in periodi anche molto distanti nel tempo, a un elevato indebitamento pubblico si associa una più bassa crescita economica.

Tutto apposto? Non proprio. Ricerca 1 altro non è che il lavoro del 2010 di Reinhart&Rogoff (R&R2010). Ricerca 3 è invece l’ormai celebre (nei media) lavoro in cui Herndon&Ash&Pollin (H&A&P) trovano degli errori veri, più una serie di errori presunti, in R&R2010. Errori che comunque da qualche tempo non erano più rintracciabili in Ricerca 2, che a sua volta è un altro lavoro di Reinhart&Rogoff (R&R2012), successivo quindi a R&R2010 ma antecedente a H&A&P2013.

A questo punto, spero siate giustamente confusi. Il primo motivo di confusione è che avete letto da qualche parte che H&A&P mandano gambe all’aria tutti i risultati di R&R. Invece io sono qui a mostrarvi come R&R2010, R&R2012 e H&A&P siano sostanzialmente in accordo fra loro nel replicare il Risultato. Il secondo motivo di confusione è che forse non vi capacitate di come sia possibile che ci sia accordo sui risultati quando proprio H&A&P hanno scoperto degli errori in R&R2010. Scusatemi, ma per rispondere a questa questione devo accennare a degli aspetti un po’ noiosi. Il lavoro di ricerca è in gran parte questo: un sacco di sudore nel curare dettagli noiosi, il tutto spessissimo per non raggiungere alcun risultato importante che possa essere dato in pasto alla stampa, ai blog, agli uomini potenti. La ricerca di qualità è fatta di noiosa lentezza, di pedanti dettagli, e di frequentissima assenza di risultati mirabolanti. Tutto l’opposto del quick, dirty, extreme che però piace tanto a un certo tipo di pubblico, e che quindi attrae come una sirena chi il lavoro di ricerca lo sa fare. Se siete curiosi e volete dunque avere risposte all’apparente confusione che vi ho creato, vi suggerisco di leggere i prossimi paragrafi, in cui ho fatto del mio meglio (spero sia sufficiente) per riassumere e fugare tutti i dubbi su ciò che veramente è accaduto. Se invece non siete interessati ai noiosi dettagli, potete saltare l'intera prossima sezione.

I dettagli noiosi

Ci sono tre aspetti che H&A&P2013 contestano a R&R2010: (i) gli errori di calcolo nel foglio di Excel, (ii) l’esclusione di alcuni Paesi dal campione utilizzato per il calcolo, e (iii) l’utilizzo nel calcolo di un metodo di “pesatura” dei diversi Paesi che a H&A&P non piace.

(i) Gli errori di calcolo consistono nell’aver fatto una media fra le celle che vanno dalla riga 30 alla riga 44, invece che dalla riga 30 alla riga 49. Questi errori di calcolo sono stati prontamente riconosciuti da R&R (che R&R abbiano fornito volontariamente ad altri ricercatori il proprio foglio di lavoro Excel mi pare provare in modo rassicurante che R&R non abbiano volontariamente truccato i propri risultati. Si tratta piuttosto di un errore materiale). Ad ogni modo, gli errori di R&R provano una grave disattenzione degli autori, ma non cambiano in alcun modo sostanziale i risultati del loro lavoro, che su questo tema tra l’altro si compone non di uno ma, come visto, di vari articoli scientifici.

(ii) L’esclusione di alcuni Paesi, e solo in alcuni periodi storici, dal campione utilizzato per il calcolo. H&A&P mostrano in particolare come l’esclusione della Nuova Zelanda per gli anni 1946-1949 porti, quando in aggiunta si utilizzi (iii) il metodo di “pesatura” da loro suggerito, ad una sostanziale revisione verso l’alto nella stima della crescita media dei Paesi altamente indebitati, cioè di quelli con rapporto debito/Pil superiore al 90%. Non è vero, dicono dunque H&A&P, che l’alto debito faccia così male alla crescita...

Fermiamoci un attimo. All’inizio del post vi ho riportato due citazioni in cui sembra che sia R&R2010 che H&A&P trovino esattamente lo stesso risultato: la crescita annua dei Paesi con debito sotto del 90% del PIL è di poco più del 3%, mentre la crescita annua dei Paesi con debito sopra al 90% è di poco più del 2%. Ma com’è possibile che sia R&R2010 sia H&A&P trovino, per i Paesi al di sopra del 90%, la medesima crescita (poco più del 2%) quando invece nel paragrafo appena sopra vi ho detto che H&A&P fanno una sostanziale revisione al numero dato da R&R2010? Insomma, R&R2010 e H&A&P trovano circa lo stesso numero o ne trovano due sostanzialmente diversi?

E qui non mi resta che tediarvi nuovamente con dei noiosi dettagli. Il punto è che R&R2010 riportano due misure di crescita annua per i Paesi sopra la soglia del 90% di debito. Una misura è la crescita mediana, che è la misura contenuta nel passaggio citato all’inizio del post. L’altra è la crescita media, che risulta, nei conti di R&R, essere sostanzialmente più bassa della mediana (mentre la mediana è poco più del 2%, la media è appena sotto allo 0%). È bene notare che, nel lavoro originale del 2010, R&R non pongono alcun particolare accento nè sulla mediana né sulla media: li calcolano tutti e due, vedono che sono entrambi più bassi quando il debito supera la soglia del 90% del PIL, e concludono che i dati mostrano che Paesi altamente indebitati crescono sostanzialmente di meno degli altri. Il lavoro di H&A&P, invece, tralascia completamente di ri-calcolare la mediana riportata da R&R2010, e si focalizza solo sulla media. In sostanza, il contributo di H&A&P è molto semplice: H&A&P mostrano come, una volta corretti alcuni errori materiali relativamente di poca importanza quantitativa, e una volta utilizzati sia un campione diverso di Paesi, sia una diversa metodologia di pesatura, la media di crescita nel database di R&R coincide sostanzialmente (anche se non totalmente) con la mediana riportata dagli stessi R&R2010, che a sua volta coincide con la media calcolata in R&R2012, che a sua volta è confermata da altri e vari studi...H&A&P di fatto validano ulteriormente la robustezza dei risultati del 2012 degli stessi R&R, e mostrano che R&R hanno fatto benissimo a seguire nel 2010 la buona prassi di riportare, come test di robustezza dei risultati, sia la media che la mediana. Così facendo, infatti, R&R2010 si sono “assicurati” che il loro risultato principale fosse meno dipendente da eventuali errori materiali (che ci sono stati) su singoli Paesi, da eventuali esclusioni/re-inclusioni di singoli Paesi, e da eventuale diversa “pesatura” dei singolo Paesi.

In fondo, non stupisce che le revisioni di H&A&P, unite alla loro diversi criteri di inclusione dei Paesi e di “pesatura”, portino ad ottenere valori che sostanzialmente confermano sia la mediana di R&R2010 che la media in R&R2012. Infatti, come detto sopra e come più volte rimarcato da H&A&P, la revisione alla media riportata da R&R2010 è in gran parte dovuta all’effetto congiunto dell’inclusione nel campione, e alla sua particolare metodologia di pesatura, delle osservazioni relative alla Nuova Zelanda nel periodo 1946-1949. Il lavoro di H&A&P in concreto non fa altro che mostrare che la media di R&R2010 è molto sensibile ai valori “estremi” osservati per un singolo Paese per un periodo abbastanza breve. La mediana, invece, è molto meno sensibile a questi valori “estremi” (e potenzialmente fuorvianti). Surprise, surprise? Non esattamente, infatti l’insensibilità della mediana ai valori estremi è proprio il motivo per cui, a mò di test di robustezza, è consigliabile inserirne il calcolo accanto a quello della media. L’unica sorpresa vera sembra piuttosto essere che R&R2010 non abbiano perso tempo a chiedersi quale fosse il probabile outlier che faceva così tanto divergere la loro media dalla loro mediana. Magari se l’avessero fatto si sarebbe pure accorti del loro errore in Excel. Ma porsi certe questioni di “dettaglio” implica il voler prendersi il tempo di non fare le cose quick and dirty...Diamo però atto che il peccato dell’aver scelto la via quick and dirty è stato almeno compensato dal naturale instinto (questo sì del buon ricercatore) di affiancare al quick and dirty un minimale test di robustezza dei risultati, cioè il calcolo della mediana. Sembra proprio che il test, questo sì, abbia tenuto.

Da notare che H&A&P usano per la loro critica a R&R2012 dei dati che sono sbagliati. Quali? Ma ovviamente quelli sulla Nuova Zelanda, il nostro outlier! Fatto sta che R&R hanno costruito il proprio database usando, per quegli anni, i famosi dati di Maddison. Tuttavia i dati di Maddison, per gli anni a cavallo del 1950 in Nuova Zelanda, sono sbagliati, come indicato dall’istituto statistico neozelandese. Cose che capitano (la ricostruzione dei dati “storici” di contabilità nazionale è un lavoro problematico, e soggetto a vari potenziali errori). I risultati di R&R2010 sono meno soggetti a questo errore di quanto non siano i risultati di H&A&P proprio in quanto R&R hanno finito per escludere dai propri conti la maggior parte degli anni dove i valori di Maddison erano errati. Accortisi successivamente dell’errore nei dati della Nuova Zelanda, R&R hanno provveduto a comunicarli al Maddison Project (Il lavoro di R&R del 2012 non soffre invece di problemi sui dati della Nuova Zelanda, in quanto R&R avevano per quel lavoro gi utilizzato i dati corretti). D’altro canto, va dato atto a H&A&P di aver giustamente messo in rilievo che R&R2010 non si sono nemmeno presi la cura di spiegare perché alcuni Paesi siano stati esclusi dal campione...quick, dirty.

La morale della favola

Spero, a questo punto, che la noia sia calata come un macigno sulle spalle dei lettori che si sono sorbiti le spiegazioni dettagliate contenute nel riquadro qui sopra. Se così è, avrò raggiunto il mio obiettivo, che è il convincervi di alcune cose. Innanzi tutto, che la critica di H&A&P non sposta sostanzialmente nulla di ciò che sappiamo, anche grazie ai lavori di R&R, riguardo alla correlazione empirica fra debito e crescita. Al massimo, H&A&P non fanno altro che confermare il Risultato principale di R&R2010, quello di R&R2012 e quelli di altri lavori in questo tipo di letteratura. La seconda è che il vero peccato di R&R non è dunque stato quello di “ingannare il mondo”, nemmeno a livello involontario (il dolo invece, come detto, è da ecludersi), tramite le celle di Excel mal selezionate. Il loro primo peccato, piuttosto, è stato quello di cedere al quick and dirty. Hanno pubblicato, senza tanta cura e con la sola attenuante dell’aver inserito la mediana come test di robustezza, un lavoro che (a differenza di R&R2012) non ha nemmeno seguito un processo di peer-review. Sì, perché quando dei ricercatori della (meritatissima) fama di R&R scrivono qualcosa, quel “qualcosa” può finir per essere pubblicato alla cieca nei Proceedings di una qualche conferenza. Da questo punto di vista, quindi, la reprimenda che R&R hanno subito mi pare giustissima. Giustissimo e confortante è poi il fatto che dei ricercatori poco noti come H&A&P si siano presi il tempo, e abbiano ottenuto da R&R stessi i dati, per cercare di replicare i risultati di R&R2010.

Se la reprimenda per il quick and dirty di R&R è corretta, montare però un caso imperniato sull’idea che H&A&P abbiano svelato che il Risultato sia un inganno è, come spiegato sopra, assolutamente ridicolo. Non c’è nessun inganno: il Risultato è sempre quello, confermato e ri-confermato, anche dagli autori stessi (R&R2012). H&A&P non fanno altro, di fatto, che portare una ulteriore prova che la correlazione predicata dal Risultato effettivamente esiste. H&A&P non svelano alcun inganno perché l’“inganno vero”, se così lo vogliamo chiamare, non sta nei fogli di Excel di R&R. Piuttosto, H&A&P non fanno altro che aggiungere se stessi alla lunga lista di coloro che nell’“inganno vero” continuano a cascarci come sacchi di patate. Ma quale sarebbe questo “inganno vero”?

L’inganno non è nel calcolo della correlazione secondo cui quando i debiti pubblici sono alti la crescita media e mediana scendono. L’inganno non sta nel risultato. L’inganno sta nel voler far credere che quel Risultato statistico sia qualcosa di importante, qualcosa da cui voler magari tirar fuori una qualche ricetta prescrittiva.

Quel risultato statistico è necessariamente ottenuto buttando in un unico calderone Paesi diversi, in periodi storici diversi, in regimi monetari diversi, dove i debiti pubblici si sono creati per motivi diversi (guerre, crisi finanziarie...va dato un qualche credito a R&R di aver più volte sottolineato questo fatto, cercando di catalogare, per esempio in R&R2012, ma anche nel famoso libro del 2009, le origini dell’indebitamento), dove la stessa definizione di cosa sia debito pubblico è altamente variabile (le pensioni future sono, per esempio, una forma di indebitamento presente dello Stato, ma non sono incluse nella definizione di “debito” utilizzato nei suddetti lavori). R&R, come molti altri ricercatori, conoscono benissimo il problema del “calderone”. Il problema è che affrontarlo in modo soddisfacente è statisticamente impossibile, perché abbiamo troppi pochi dati per “controllare” statisticamente tutti gli elementi nel calderone. Legata a questa questione, in particolare, c’è il fatto che in questo caso è probabilmente impossibile mettere in piedi una batteria di test statistici che ci dica, in modo molto convincente, quanto la correlazione negativa fra crescita economica e debito pubblico sia dovuta ad una causazione che va dal debito alla crescita, piuttosto che dalla crescita al debito. L’inganno vero è credere che dobbiamo dare troppa importanza al Risultato. La teoria economica stessa ci dice, infatti, che dobbiamo ben guardarci dal dare peso a risultati che indichino che sopra una soglia predeterminata del X% di indebitamento pubblico il debito abbia un effetto particolarmente negativo sulla crescita. Proprio a causa del calderone, infatti, è altamente improbabile, se non impossibile, che la soglia X%, ammesso che esista, sia la stessa (per esempo X%=90%) per tutti i Paesi, in tutte le circostanze. Una soglia fissa del X%, quindi, non dovrebbe nemmeno esistere!

Il vero problema è che il Risultato è stato utilizzato da molti in modo ingannevole. In particolare, il Risultato è stato abbondantemente riportato dalla stampa e dai blog come una prova a favore delle misure di contenimento dei deficit pubblici attualmente in atto in varie parti del mondo. Il Risultato è così entrato a far parte dei papponi inutili e dannosi di cui si legge continuamente, e di cui si nutrono ragionamenti, posizioni, e scontri che non trovo altro modo di definire se non col termine raccapriccianti (un ulteriore esempio di pappone raccapricciante è quello sui moltiplicatori fiscali, altra questione importante ma empiricamente non ancora risolta e, purtroppo, difficilmente risolvibile. Ragionevolezza e consapevolezza suggerirebbero dunque di prendere con le pinze i vari studi che si susseguono, studi che invece vengono usati nel pubblico dibattito come una clava). La situazione è talmente raccapricciante che non solo il lavoro H&A&P è stato falsamente venduto al pubblico come un modo per smentire il Risultato. Non solo H&A&P non fanno altro che perpetuare essi stessi il “vero inganno” sulla presunta rilevanza pratica del Risultato (H&A&P concludono dicendo “Il fatto che i risultati di R&R sono sbagliati dovrebbero perciò portarci ad una rivisitazione dell’agenda di austerity sia in Europa che negli USA”). Ma, ciliegina sulla torta, il polverone alzato dal lavoro di H&A&P ha addirittura portato ad una serie di articoli sul New York Times in cui R&R e H&A&P si confrontano a distanza sulle metodologie e sui risultati (il tutto, ovviamente, senza neanche poter inserire tabelle esplicative dei dati. In fondo, cosa ci si può aspettare da un dibattito scientifico su un quotidiano?).

Ora chiediamoci, ma di che raccapricciante livello di dibattito pubblico stiamo parlando? Esiste anche solo una persona seria, all’interno della professione, che crede che lo spostamento di qualche decimo di punto (sia in un verso che nell’altro!) nelle medie o mediane delle stime di R&R debba avere un seppur vago effetto sull’ “agenda di austerity sia in Europa che negli USA”?

La risposta all’ultima domanda credo non possa che essere negativa. Non ho alcun dubbio che la quasi totalità degli economisti professionisti, siano essi in accademia o nelle varie istituzioni pubbliche, sappiano benissimo quando profondi sono i limiti delle analisi empiriche del tipo sopra citato (di nuovo, lo stesso vale per la miriade di lavori empirici sui “moltiplicatori fiscali”). Non c’è nulla di male nel fatto che certe analisi abbiano dei limiti: non si tratta di dire che gli autori sono degli incapaci, non si tratta nemmeno di suggerire che certe analisi non vadano nemmeno fatte (io sono tra quelli che credono che anche analisi parziali possano servire a imparare qualcosa, o a tracciare almeno l’inizio di una strada fruttuosa). Si tratta piuttosto di riconoscere che i dati a disposizione sono quello che sono. Le scelte da fare in Europa, come altrove, non possono basarsi (nè, mi sento di rassicurarvi, si basano nella realtà) su un foglio di Excel di R&R.

Ma allora, perché tanta pubblicità sui media per questioni che, in buona parte, andrebbero affrontate con toni pubblici molto più bassi, per esempio limitando le discussioni, magari accese, sui noiosi e dettagliati metodi di “pesatura” delle osservazioni ad un consesso scientifico, invece che sul New York Times?

Lascio a voi la risposta, che secondo me ha a che fare con le mode,con la visibilità pubblica (che si ottiene più facilmente con l’extreme), con la voglia di contare davvero, con il buio assoluto in cui spesso brancolano i policy-makers che, a differenza degli accademici, non hanno il lusso di poter aspettare tempi o dati migliori prima di prendere le decisioni (anche il non-decidere-ora è già una decisione, con possibili ripercussioni immediate. Spesso il quick and dirty appare quindi come meglio del niente). Nel girone infernale delle diatribe raccapriccianti sono cascati, questa volta, anche R&R. In fondo, in queste diatribe raccapriccianti ci sono volontariamente scesi, e da queste diatribe raccapriccianti hanno tratto una certa visibilità. Insomma, ci hanno un po’ marciato sopra. Ed ora, il quick, dirty and extreme torna indietro a colpire come un boomerang. La giusta pena del contrappasso è che, invece di spiegare il perché ed il per come dei propri numeri di fronte ad un consesso di colleghi economisti, si trovano a spiegarli e giustificarsi dalle pagine di un quotidiano.

Ancora due considerazioni, prima di terminare. La prima, più che una considerazione, è un esercizio che propongo come metodo per selezionare la qualità dei blog o dei giornalisti che leggete. Blogs e giornalisti sono parte integrante del meccanismo mediatico del quick, dirty, extreme. Personalmente credo che la qualità di un giornalista o di un blogger possa intuirsi anche dal modo in cui ha trattato la vicenda R&R. Se in passato il blogger in questione vi ha detto che i lavori di R&R sono una importante prova a favore dell’austerity in Europa, allora cambiate blogger. Allo stesso tempo, se in questi giorni il blogger vi ha raccontato che il lavoro di H&A&P conferma che l’austerity in Europa è un errore allora, esattamente come detto sopra, cambiate letture. In entrambi i casi, vi trovare di fronte ad un commentatore che non cerca altro che vendervi un’idea preconfezionata. Uno che non ha le competenze, il tempo, o la voglia per leggere i lavori che va sbandierando in giro. Uno che replica luoghi comuni, anche se magari questi luoghi comuni sono presi dalla newsletter di una banca d’investimento o dall’abstract di un lavoro accademico. Ho fatto il seguente esercizio. Ho cercato su Google il nome dei blogger che vanno per la maggiore, seguiti dalle parole chiave quali Reinhart Rogoff. I più attivi di recente sono stati, ovviamente, gli esultanti blogger “anti-austerity”. Tra di loro, il commento di alcuni è stato del tipo “l’ho sempre detto/ve l’avevo detto io/finalmente ci sono arrivati anche loro...”. Beh, evitateli, apparentemente sapevano che c’erano errori anche senza aver mai visto il foglio di Excel di R&R. Evitate quei blogger che vi dicono che H&A&P hanno finalmente smentito il Risultato, che invece è ancora lì. Ma, cosa ancora più importante, evitate quei blogger che perpetuano, non importa se per incapacità o per fini di auto-promozione, l’inganno vero di farvi credere che la verità o meno del Risultato abbia una certa importanza per decidere se l’“austerity” in Europa sia stata o no una scelta corretta.

Sono stato fin qui abbastanza critico di alcuni tratti dell’atteggiamento di R&R, ma anche di quello di H&A&P. Concludo, però, respingendo al mittente le accuse secondo cui l’affaire R&R dimostra come gli economisti siano ancora distanti dai criteri etico-scientifici vigenti, secondo costoro, in altre discipline (un refrain che ogni tanto alcuni intonano...vabbè ognuno c’ha le proprie fisse e i propri irrisolti). Piuttosto, l’affaire R&R mostra, a mio avviso, quali siano le trappole in cui gli scienziati, di qualsiasi disciplina, possono cadere quando si trovano attirati dalle sirene e dalla pubblicità del quick, dirty extreme. Sono sirene che cantano forte ogni qualvolta lo scienziato si trovi a lavorare su temi caldi, dove gli interessi economici e quindi l’attenzione del pubblico sono sostanziali, e dove magari i fenomeni empirici sono particolarmente complessi da misurare con certezza (i Risultati andrebbero perciò presi con le dovute pinze). Esempi di questa situazione sono il tema scottante del cambiamento climatico (se n’è parlato anche qui), o la questione dell’effetto sull’uomo e sull’ambiente dell’utilizzo di organismi geneticamente modificati. È bene poi ricordare, infine, che nessuno ha accusato R&R di aver volontariamente truccato i dati. Né il lavoro di R&R è stato pubblicato su prestigiose riviste che utilizzano processi di peer-review (anche se non mi sarei stupito se un eventuale processo di peer-review non avesse scoperto l’errore materiale). Niente a che fare, insomma, con quanto accaduto in alcuni casi infinitamente più gravi, ma che di certo non giustificano un attacco ad altezza uomo contro l’intera comunità scientifica di riferimento.

Nota del 9/5/2013

Il 5 maggio, proprio mentre scrivevo questo post, Reinhart&Rogoff pubblicavano una dettagliata errata corrige al loro lavoro. Prima di discuterla, vorrei consigliarvi un link, che in un commento in calce al post è stato portato alla mia attenzione oggi da un lettore. In particolare, il grafico e le tabelle nel link confermano che, una volta letto R&R2010 congiuntamente con R&R2012, appare abbastanza chiaro che H&A&P non fanno altro che ri-calcolare la media della crescita del PIL e mostrare che essa coincide sostanzialmente con la mediana calcolata da R&R2010 e che col risultato trovato da R&R in altri lavori.

Veniamo ora alla nota contenente l'errata corrige di R&R2010. La nota è molto dettagliata, ma vorrei soffermarmi sugli ultimi tre blocchi della Tabella 1 a pagina 8, limitandomi a tre commenti generali. Il primo commento è che, di nuovo, qualsiasi metodologia venga utilizzata, il Risultato è confermato. Il secondo è che l'altezza dello "scalino" fra l'intervallo con debito 60-90% a quello >90% varia da un massimo del 2,2% ad un minimo dello 0,3%, a seconda del periodo usato per selezionare il campione (intero campione oppure solo periodo "post bellico") e a seconda della statistica considerata (media oppure mediana). Infine, indipendentemente dalla scelta fra media o mediana, l'utilizzo del campione "post bellico" porta sempre ad una relazione strettamente decrescente fra intervalli di debito e crescita del PIL. La possibilità di intravvedere un effetto soglia ad un livello di indebitamento pari al 90% del PIL non è dunque un risultato molto robusto. Ma, come spiegato nel testo del post, e come ho ribadito anche nei commenti, da sempre bastava una elementare riflessione critica per rendersi conto che non c'è mai stato alcun motivo per dare rilievo né teorico né statistico a tale presunto effetto "soglia". Niente di sconvolgente, dunque.

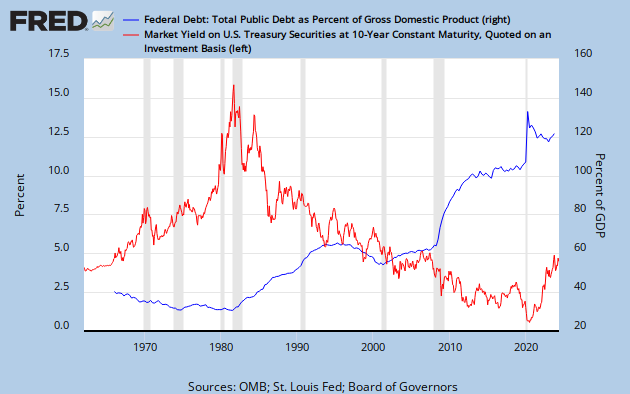

Ad alto debito corrispondobo bassi tassi e viceversa, quindi non è affatto detto che vada come sostieni. Anzi, è piuttosto ovvio che quando il debito è alto, la CB intervenga per abbassare i tassi. Senza contare peraltro che la stessa CB compra molti titoli (nel caso della FED, attualmente quasi tutti) e quindi lo stato si indebita n larga parte con se stesso.

Ad alto debito corrispondobo bassi tassi e viceversa, quindi non è affatto detto che vada come sostieni. Anzi, è piuttosto ovvio che quando il debito è alto, la CB intervenga per abbassare i tassi. Senza contare peraltro che la stessa CB compra molti titoli (nel caso della FED, attualmente quasi tutti) e quindi lo stato si indebita n larga parte con se stesso.

Il risultato principale di R&R era la famosa soglia del 90%. Ora non c'è più. Come si fa a dire che va più o meno tutto bene? Non solo: il paper di R&R non ha mai analizzato la direzione della causalità: è il debito che porta a bassa crescita o il contrario? Ebbene... http://keynesblog.com/2013/05/06/la-bassa-crescita-fa-aumentare-il-debito-pubblico/

No, confondi "risultato principale" con "fatto da loro enfatizzato per avere maggiore portata mediatica". Il risultato principale e' che una correlazione con debito c'e'. L'enfatizzazione dell'effetto soglia invece e' tutta inventata da loro e dai media... nessuno peraltro ci avrebbe spiegato perche', teoricamente, passare da 89 a 91 dovrebbe fare sta gran differenza.

Non può non essere chiaro che dalla logica keynesiana che vuole che, un aumento della domanda effettiva spinto dalla spesa pubblica finanziata con il debito, contribuisca a sostenere la crescita del PIL debba conseguire anche l'opposto. Quindi se si ritiene che il livello di PIL corrente sia stato raggiunto anche attraverso la spesa pubblica a debito, nel momento in cui il livello del debito non consente più di sostenere certi livelli di spesa pubblica, anche il PIL dovrà risentirne. Il problema è stabilire qual è il livello di debito pubblico che richiede un maggior controllo (o riduzione) della spesa. Secondo R&R tale livello si situa intorno al 90% del PIL ma, trattandosi di un risultato statistico, non può essere considerato valido in assoluto per ciascun paese. Si tratta di una soglia tendenziale, che sarebbe sbagliato ignorare.

Quindi il vero problema è se si può spendere illimitamente (indebitandosi) oppure no. Credo che la risposta sia scontata: la spesa a debito è necessariamente limitata dalla disponibilità dei creditori a finanziarla. Si tratta di un atteggiamento perfettamente legittimo. Chi non ne tiene conto è poco assennato.

Fino alla fine. E magari capire. L'articolo dice che la soglia rimane (non ce ne frega niente della soglia, ma rimane). Non sei d'accordo? Hai fatto dei conti? Su cosa basi la tua affermazione che rimane? Il riassunto del risultato della ricerca 3 all'inizio dell'articolo e' incorretto? Dove? In che senso? Tra persone serie si discute cosi'.

E chi lo di qual era il risultato principale? Gli autori? I contro-autori? Il Financial Times? Il mio macellaio?

In una discussione fra professionisti "il risultato principale" non è una cosa data da domine iddio, nè tanto meno dagli autori (detta brutalmente, il "riusultato principale", dal punto di vista degli autori, è quella cosa da mettere nell'abstract per massimizzare la probabilità ex-ante di essere pubblicato). In una discussione fra esperti, ogni individuo che ascolta e prende parte al dibattito é capace di analizzare in modo critico quello che gli viene parato davanti.

A me pare abbastanza chiaro che la mitica "soglia del 90%" non è per nulla il risultato principale. E', al massimo, una di quelle cose che si dicono e si scrivono per rendere sexy un risultato (ma sexy agli occhi e ai gusti di chi? di un pubblico di accademici? di policy-makers? del New York Times?...).

Affinchè io mi metta anche solo a considerare l'ipotesi dell'esistenza di una soglia fissa e uguale per tutti mi devono per lo meno presentatare uno straccio di test statistico. Cosa che R&R non fanno in alcun modo. Loro dividono, per comodità, i rapporti debito/PIL nei seguenti quattro intervalli, che denoto con la lettera X: X1=0-30%, X2=30-60%, X3=60-90%, X4=90-infinito%. Per ognuno di questi gruppo calcolano una statistica, chiamiamola G(X), che sia una misura centrale di crescita del PIL quando il debito é nell'intervallo X.

Mai, mai e poi mai nessuno, fosse anche Roberto Lucas, può convincermi che empiricamente ci sia una forte non linearità ("effetto soglia") in corrispondenza dell'intervallo X4, posto che gli intervalli siano definito così come fatto da R&R. Infatti l'intervallo X4 è infinitamente più grande di tutti gli altri intervalli! Questo fa sì che se, per assurdo, la soglia vera (cioè quella non proveniente da una discretizzazione brutale degli intervalli) fosse attorno a X=150% allora é possibilissimo che quella soglia "vera" appaia nella discretizzazione di R&R al livello 90%, invece che a 150%. E ciò p'er il banalissimo motivo che 150% appartiene all'intervallo X4! R&R non fanno nulla per verificare che non esista questo tipo banalissimo di problemi. Né uno scatterplot dei dati, nè qualsiasi altra cosa santiddio, tipo l'aumentare il numero di intervalli X per coprire in modo più preciso i livelli di debito sopra al 90%. Perché non fanno almeno questo banalissimo esercizio di aumentare gli intervalli? Non lo so, ma credo sia abbastanza ovvio che non lo fanno perchè hanno così pochi punti nella loro stima, che aumentano il numero di intervalli posizionatio al di sopra del 90% allora rischiano di avere intervalli con una sola osservazione. Questo in effetti avrebbe dei vantaggi: fare la mediana di una sola osservazione é a prova di Excel.

Queste questioni, che rendono impossibile anche solo pensare che R&R abbiano trovato una soglia di alcunchè, non le vedo io perchè sono Einstein. Ma le vede chiunche abbia i) letto il paper, o almeno visto il grafico! ii) abbia una minimissima idea di come si trattano dei dati statistici. Ergo, nessuno tra gli economisti che abbiano soddisfatto il criterio i) (il ii) lo do per default come assodato) può mai aver pensato che il vero risultato di R&R sia quello che dici tu. Infatti, tra gli economisti che han letto R&R (che han scritto più di un paper esattamente sullo stesso tema...) ne ho mai incontrato uno che pensasse che il risultato, se mai ce ne fosse stato uno degno di nota, era quello delle "soglie".

Ora, permettimi, quello che scrive il keynesblog.com neanche lo leggo. Ho già letto il paper (più altri paper degli stessi autori e dello stesso tema). Cosa può dunque mai darmi in più il keynesblog.com sull'esistenza o meno delle soglie? L'autore del keynesblog.com ti dice che il risultato importante (non il risultato mediatico per i gonzi) era quello delle soglie? Beh, io considererei di lasciar perdere la lettura di quell'autore (che, btw, neanche so chi sia dato che è un blog che non ho mai sentito).

PS. Mi sono reso conto ora che lo scatterplot e l'aggiunta di intervalli é un modo così elementare per fare un minimo di controllo sull'esistenza di un "effetto soglia" che H&A&P l'han fatto proprio nel loro lavoro linkato. Loro, diversamente da R&R, sono riusciti a fare questo esercizio in modo non ridicolo perchè hanno a disposizione moltissime più osservazioni di R&R. Queste osservazioni addizionali sono proprio dovute al diverso metodo di pesatura utilizzato da H&A&P (su quale sia il "miglior" metodo di pesatura, in questo caso, ognuno può farsi un giudizio, sono entrambi per lo meno ragionevoli). Il risultato lo vedi nella figura 4 in appendice. In effetti, vien da dire (ma di nuovo, sarebbe ridicolo farne una questione importante, con questi dati...) che la soglia del 90% di R&R era una soglia (una non-linearità) solo un po' debole (un po' di non-linearità appare nel grafico poco sotto al 90%). Ma il vero risultato è un altro! Lasciamo stare la soglia del 90%, che è un nonnulla! Infatti, non solo H&A&P mostrano una correlazione negativa fra indebitamento e crescita economica (ma questo lo sapevamo già: è il Risultato!). Piuttosto la vera scopertà è che la sogli è lo zero%! Guarda come crolla la crescita del PIL nell'intervallo di debito 0-30%!!! Eliminiamo quindi totalmente il debito pubblico, questo è il vero risultato di H&A&P!!